|

|

|

||||||

|

|

|

|

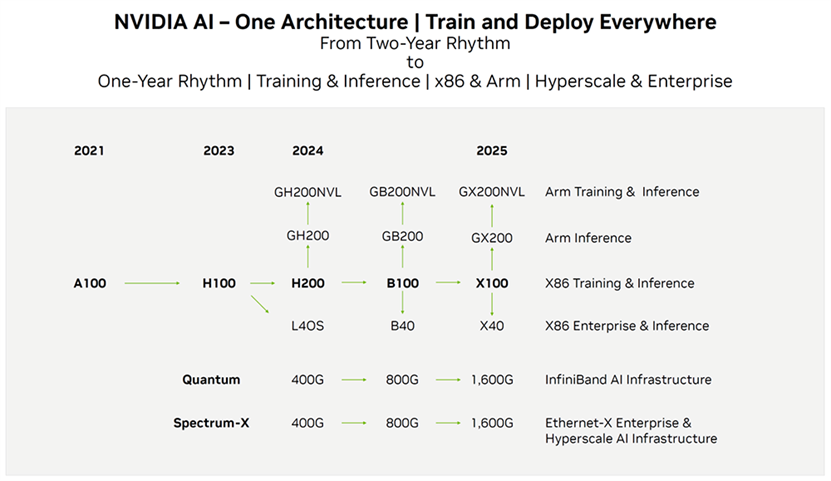

英伟达数据中心/AI产品迭代路线图(图源:英伟达)

AI 和 HPC 处理器正在展现出强大功能。

全球最大的服务器制造商之一戴尔透露了英伟达即将推出的人工智能 GPU,代号为 Blackwell。显然,这些处理器的功耗高达 1000 瓦,比上一代处理器的功率增加了 40%,需要戴尔利用其工程独创性来冷却这些 GPU。戴尔的评论也可能暗示了 Nvidia 即将推出的计算 GPU 的一些架构特点。

戴尔首席财务官 Yvonne Mcgill 表示:“显然,我们对 H200 所发生的变化及其性能改进感到兴奋。” “我们对 B100 和 B200 所发生的事情感到兴奋,我们认为这实际上是另一个区分工程信心的机会。我们在热方面的特征,你真的不需要直接液体冷却来达到能量密度每个 GPU 1,000 瓦。”

由于不了解 Nvidia 关于其 Blackwell 架构的计划,我们只能参考散热的基本经验法则,即芯片面积的散热通常最高约为每平方毫米 1W。

从芯片制造的角度来看,这就是有趣的地方:Nvidia 的 H100(基于定制 4nm 级工艺技术构建)已经消耗了约 700W,尽管包含 HBM 内存的功率,并且芯片芯片为 814^2大,因此每平方毫米的功耗低于 1W。该芯片采用台积电定制的性能增强型 4 纳米级工艺技术构建。

Nvidia的下一代GPU很可能会基于另一种性能增强的工艺技术构建,我们只能猜测它将采用3nm级的工艺技术构建。考虑到芯片消耗的功率以及所需的散热量,有理由认为 Nvidia 的 B100 可能是该公司的第一个双芯片设计,从而使其具有更大的表面积来处理产生的热量。我们已经看到 AMD 和英特尔采用了具有多个芯片的 GPU 架构,因此这将符合其他行业趋势。

当谈到高性能人工智能和高性能计算应用时,我们需要考虑以 FLOPS 为单位衡量的性能,以及实现这些 FLOPS 和冷却产生的热能所需的功耗。对于软件开发人员来说,重要的是如何有效地使用这些 FLOPS。对于硬件开发人员来说,重要的是如何冷却产生这些 FLOPS 的处理器。戴尔表示,这就是其技术有望超越竞争对手的地方,这也是戴尔首席财务官谈论英伟达下一代 Blackwell GPU 的原因。

“明年的 B200 就会出现这种情况,”麦吉尔说,他指的是 Nvidia 的下一代 AI 和 HPC GPU。“我们有机会真正展示我们的工程技术以及我们的行动速度,以及我们作为行业领导者所做的工作,以利用我们的专业知识使液体冷却大规模发挥作用,无论是在流体化学和性能方面,还是在我们的互连工作,我们正在做的遥测,我们正在做的电源管理工作,它确实使我们能够准备好将其大规模推向市场,以利用这种令人难以置信的计算能力或强度或能力,这些能力将存在于市场。”

近日,英伟达宣布将在即将到来的GTC2024大会上发布全新的Blackwell架构的B100 GPU。据内部消息,B100在整体性能上实现了显著提升,相较于当前的H系列。这款GPU不仅增强了HBM内存容量和AI性能,还引入了创新的液冷散热技术,取代了以往的风冷散热方案。英伟达CEO黄仁勋认为,浸没式液冷技术将成为未来发展趋势,并有望引领整个散热市场进行革新。因此,从B100开始,英伟达未来所有产品都将采用液冷散热技术。这一重大技术革新对AI服务器市场产生了深远影响。 英伟达的B100液冷项目由代工厂英业达负责提供。英业达方面表示,今年AI服务器市场仍将以英伟达产品为主导,预计B100产品将于第四季度正式量产。此外,随着高性能应用的普及,对散热需求极高的芯片逐渐增多,这使得液冷技术成为服务器温控产业未来发展的重要方向。

华尔街分析师Hans Mosesmann认为,液冷技术是克服运算挑战的关键,有助于为超大规模云端服务铺平道路。他将超微电脑的目标价从700美元上调至1300美元,并维持买入评级。这是因为超微电脑采用了液冷服务器技术,能有效为高速运转的AI计算机降温。由此可见,液冷技术在AI服务器领域的应用前景广阔,或将成为未来市场竞争的一大亮点。

总之,英伟达全新B100 GPU的推出,标志着液冷散热技术在AI服务器领域的广泛应用。随着各大厂商纷纷跟进,液冷技术有望引领散热市场革新,并为AI服务器产业带来更为广阔的发展空间。在这场技术变革中,率先采用液冷技术的厂商将占据市场优势,进一步推动AI服务器市场的发展。

免责声明:文章来源网络及其他媒体平台,转载目的在于传递更多信息,仅代表作者个人观点,不确保文章的准确性,如有侵犯版权请告知,我们将在24小时内删除!

|

|