|

智算中心液冷产业全景研究报告 (2025年)

中国信息通信研究院云计算与大数据研究所2025年8月

版权声明

本报告版权属于中国信息通信研究院,并受法律保护。转载、摘编或利用其它方式使用本报告文字或者观点的,应注明 “来源:中国信息通信研究院 ”。违反上述声明者,本院将追究其相关法律责任。

前言

算力时代的蓬勃浪潮正深刻重塑着底层基础设施的发展格局,传统数据中心正加速向以高密度、高算效为主要特征的智算中心迭代演进。为破解 IT设备散热难题,并有效控制运行能耗,智算中心采取了一系列技术革新,其中的一项关键举措便是应用液冷技术。

本报告以智算中心液冷技术为核心切入点,聚焦液冷产业链的上、中、下游各环节,涵盖液冷系统关键零部件、液冷 IT设备、液冷整体解决方案及液冷智算中心实践等重要领域。通过梳理和分析各细分市场产业竞合情况、前沿技术、热点产品以及未来发展趋势,旨在多维度、立体化呈现智算中心液冷产业的整体图景与发展脉络。

为推动我国算力领域液冷产业实现高质量发展,本报告认为,在巩固优势方面,应持续培育壮大液冷产业市场,充分释放市场规模效应;在弥补短板方面,应强化应用牵引,加快关键核心技术研发与创新突破;健全标准规范体系,推动协同创新与开放解耦。

由于智算中心液冷市场产业链条长,关联覆盖广,报告内容疏漏在所难免,敬请读者给予批评指正。

如需交流建议,欢迎联系报告团队: dceco@caict.ac.cn。

目录

报告目录

一、政策与需求合力推动液冷产业蓬勃发展

(一)我国智算中心迈向提质增效新阶段

(二)液冷系统重构智算中心散热新范式

二、不同技术路径呈现出多样发展态势

(一)冷板式液冷技术应用广泛

(二)浸没式液冷技术稳步发展

三、智算中心液冷产业全景态势

(一)全景态势

(二)液冷系统零部件

(三)液冷 IT 设备

(四)液冷系统技术服务

(五)液冷技术应用赋能

四、智算中心液冷产业发展建议

(一)加速技术研发迭代,探索多领域应用场景

(二)加强标准规范制定,引导产业全链条有序发展

(三)推动分类分级与权责划分,健全液冷产品质量控制体系

(四)强化产业链协作,构建良好的液冷产业链生态循环

图目录

图冷板式液冷系统原理图

3图浸没式液冷系统原理图

5图智算中心液冷产业规模测算

6图智算中心液冷产业全景

7图冷板领域

8图冷却液领域

10图快速接头领域

12图冷量分配单元(CDU)领域

14图一次侧系统领域

16图冷却介质槽领域

18图液冷管路及阀门组件领域

20图冷板式液冷服务器领域

22图浸没式液冷服务器领域

24图液冷交换机领域

26图液冷光模块领域

28图液冷机柜系统解决方案领域

30图液冷机房级解决方案领域

32图液冷智控系统领域

33图液冷智算中心建设领域

35图液冷智算中心服务

一、政策与需求合力推动液冷产业蓬勃发展

(一)我国智算中心迈向提质增效新阶段

算力结构持续优化,智算中心加速布局。近年来,我国智能算力规模持续扩大,智能算力占算力总规模比重进一步提升。截至 2025年 6月,我国智能算力规模达到 788EFLOPS(FP16)。智能算力的旺盛需求同样带动了智算基础设施建设热潮,我国境内拟建、在建、已建成的智算中心项目数量持续突破,项目地点遍布 30余座城市,已成为我国综合算力基础设施体系中的重要组成部分。

节能降碳政策频出,推动绿色技术深化应用。 2024年我国算力中心总耗电量达到 1660亿 kW·h,约占全社会总用电量的 1.68%。为引导我国算力基础设施实现绿色低碳高质量发展,国家有关部门出台了一系列政策举措,鼓励液冷等节能技术应用。国家发展改革委等四部门联合印发的《数据中心绿色低碳发展专项行动计划》提出, “因地制宜推动液冷、蒸发冷却、热管、氟泵等高效制冷散热技术,提高自然冷源利用率 ”。工业和信息化部等六部门联合印发的《算力基础设施高质量发展行动计划》提到, “支持液冷、储能等新技术应用 ”。

(二)液冷系统重构智算中心散热新范式

液冷技术可显著降低智算中心运营成本。液冷是一种新兴的智算中心散热形式,其相较于传统风冷散热方案更为简化,取消了冷水机组、空调末端等高能耗设备。借助冷却工质较高的比热容与优异的导热性能,液冷系统能够支持智算中心单机柜功率密度轻松突破 40kW。对智算中心运营方而言,引入液冷技术有助于降低后期运维成本与能源支出。同时,在面对土地资源紧张、土建成本高昂等诸多不利条件时,可通过部署液冷系统解决服务器高密部署的散热难题,以实现算力规模扩展与初期投资的高效平衡。施耐德电气曾对采用不同散热技术的高功率密度部署场景进行了比较分析,结果显示,在假设算力规模相同时,对于单个机架功率为 20kW的场景,使用液冷技术可以比传统的风冷方案节省大约 10%的投资成本;而当单个机架功率增加到 40kW时,这一比例上升到了 14%。

液冷技术可解决 AI服务器高功率密度下的散热难题。智算中心部署的 AI服务器通常由内部搭载的 GPU(GraphicsProcessingUnit,图形处理器)等各类计算芯片承担计算任务。在芯片设计层面的不断优化和异构技术的加持下,虽然芯片制程逐渐逼近硅基材料的晶格结构和物理特性极限,但单个芯片的功耗仍然增加迅速。根据实验数据,当芯片功率超过 300W时,传统风冷系统散热能力便已失效,芯片热失控风险急剧升高。液冷技术利用液体比热容高于空气的优势,通过与发热元器件紧密结合,实现对芯片精准散热,芯片结温可降低约 15℃至 25℃,充分满足了高密部署场景下的芯片散热需求。

二、不同技术路径呈现出多样发展态势

智算中心液冷散热系统主要有三种形式,分别为:冷板式液冷系统、浸没式液冷系统和喷淋式液冷系统。从工程应用进展来看,冷板式液冷系统与浸没式液冷系统均已实现规模化部署,呈现良好发展态势。喷淋式液冷系统受限于喷嘴结构设计等硬件因素,以及冷却液射流或喷雾在温度均匀性和传热特性等微观层面的局限,实际工程实践较少,其发展有待进一步观察。

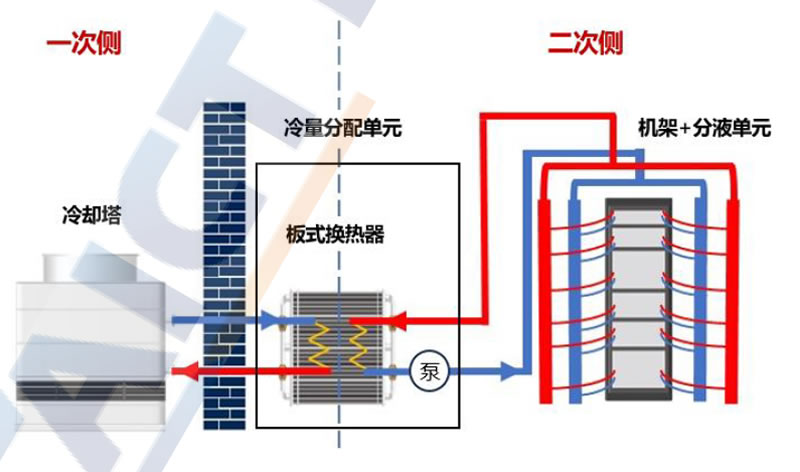

(一)冷板式液冷技术应用广泛

系统成熟可靠,工程实践广泛。冷板式液冷技术发展时间较早,在航空航天、新能源汽车等领域均具备深厚的工程实践积累。智算中心冷板式液冷系统主要包括:冷板、管路、快速接头、分液歧管、冷量分配单元与室外一次侧冷却设备等组件。冷板通常是由铜、铝等高导热金属构成的封闭腔体,服务器芯片等发热元件通过导热界面材料与冷板贴合,热量经导热界面材料传递到冷板上,并通过冷板内部冷却液循环带走热量。系统的各部分组件多由常规材料制成,生产工艺较为成熟,利于工程实施与规模化应用。此外, IT设备与冷却液工质采用间接接触方式,不必过多考虑服务器设备材料与冷却液的兼容性问题,进一步降低了系统应用门槛。

来源:中国信息通信研究院图 1冷板式液冷系统原理图

兼顾性能与成本,是液冷系统落地的现实首选。现有智算中心散热设计以风-液混合形式居多,即针对服务器芯片等局部热点采用冷板散热,而机房内其他热负荷则由精密空调承担。冷板式液冷系统在基础设施架构与运维模式上与风冷系统高度兼容,可充分借鉴成熟的风冷设计与运维经验,具备良好的工程落地基础。此外,对于风冷智算中心改造项目,采用冷板式液冷改造方式无需对服务器芯片及其他组件进行重大修改或大规模替换,可最大限度保留服务器主板原有形态,方案实施难度低、改造周期短、综合成本可控,具备较强的可操作性与推广价值。

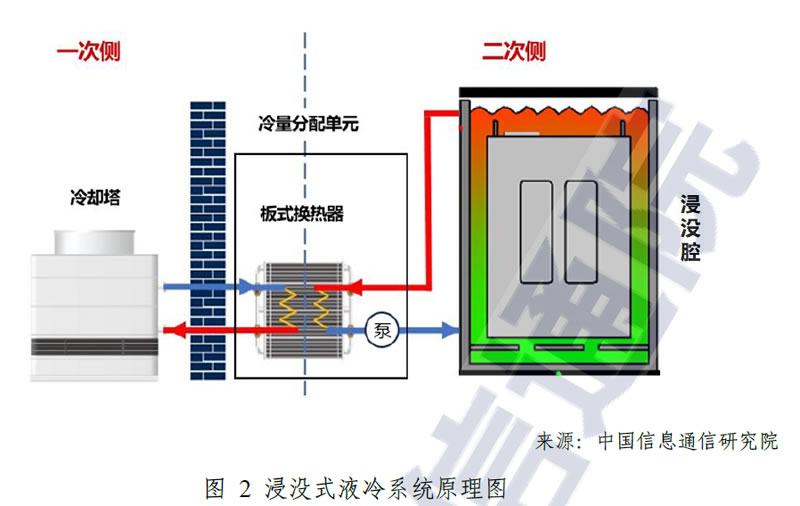

(二)浸没式液冷技术稳步发展

浸没式液冷在二次侧实现了 100%液体冷却,节能效果更优。浸没式液冷系统由浸没箱体、冷却液、冷量分配单元、室外一次侧冷源等组成,通过将服务器完全浸没于特殊定制的浸没箱体中,并与箱体内绝缘的冷却液直接进行热交换,该系统在换热效率方面具有明显优势,节能效果更为显著。根据实际工程案例和测试数据,采用浸没式液冷方案的算力中心 PUE(PowerUsageEffectiveness,数据中心能效比)可达到 1.05甚至更低,而传统模式下的算力中心的 PUE值通常在 1.3以上。

来源:中国信息通信研究院图 2浸没式液冷系统原理图

单相浸没系统具备运维优势,两相浸没技术面向极致散热需求。浸没式液冷按冷却液相态是否发生变化可分为单相式和两相式两类。单相浸没式系统采用高沸点冷却液,散热过程中冷却液始终保持液态,挥发损耗低,热力过程稳定。结合开放式箱体设计,服务器组件的维护与更换较为便利。两相浸没式液冷则将服务器完全浸没于密闭箱体,冷却液吸热沸腾汽化,蒸汽在顶部冷凝后回流完成循环。该过程可凭借汽化潜热实现更高效的热量转移,但对冷却液性能,如:高热稳定性、窄沸程、高汽化潜热等要求严苛。同时,系统须具备良好的密封性与承压能力。因此,该技术更适用于高热流密度场景下的极致散热需求。

三、智算中心液冷产业全景态势

(一)全景态势

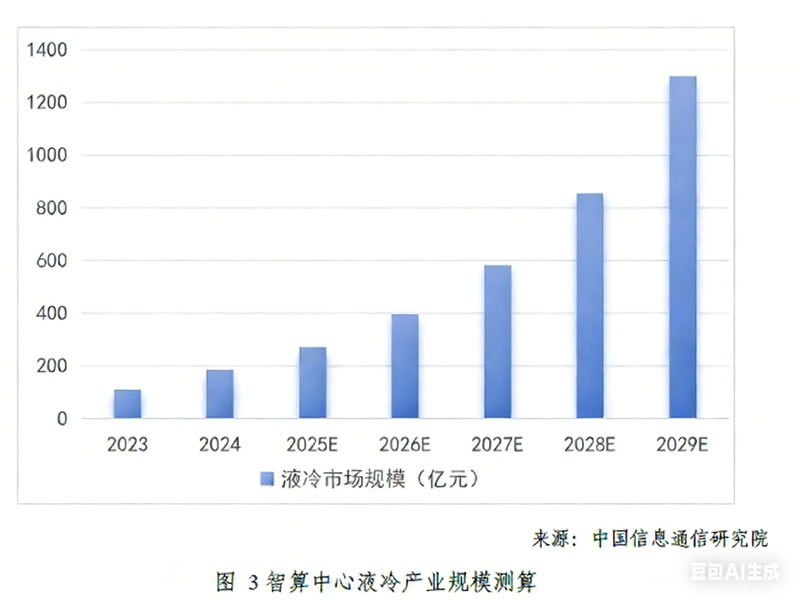

现阶段,随着液冷技术趋于成熟可靠,业界对液冷系统的认可度正不断提升,我国液冷市场规模逐年扩大。根据中国信息通信研究院测算, 2024年我国智算中心液冷市场规模达到了 184亿元,较 2023年同比增长 66.1%。预计未来经过 5年增长,到 2029年我国智算中心液冷市场将达到约 1300亿元。

来源:中国信息通信研究院图 3智算中心液冷产业规模测算

智算中心液冷产业链涵盖上游的零部件及 IT设备、中游技术服务,以及下游应用场景三个核心环节。三者相互依存,紧密协作,共同决定了液冷智算中心的底层支撑能力、应用部署门槛、运行效率及综合赋能价值。本报告围绕冷板式液冷与浸没式液冷两大主流技术路径,对智算中心液冷产业链进行梳理,旨在充分展现产业全景。

智算中心液冷产业全景研究报告(2025年)

图 4智算中心液冷产业全景来源:中国信息通信研究院

(二)液冷系统零部件

液冷系统涉及多类零部件。冷板和快速接头是冷板式液冷系统在机房侧(即二次侧)的特有组件。冷却介质槽是浸没式液冷系统在二次侧的重要组成单元。冷却液、冷量分配单元、一次侧冷源、管路及阀门组件是两类液冷系统的通用组成部分。

1.冷板

(1)领域全景

来源:中国信息通信研究院

图 5冷板领域

(2)发展态势

冷板通过与发热元件接触实现换热。冷板主要由冷板基板、流道盖板、流体通道构成。冷板基板为冷板的底层部件,通过界面材料与发热器件直接接触。流道盖板为冷板的顶层部件,与基板密封形成封闭的腔体。冷板整体预留有配管或连接口,冷却液流过流体通道,并通过与流体通道的接触实现换热。冷板的设计形态、加工工艺多样,主要分为冲压冷板、 CNC加工( CNCmachining,计算机数字化控制精密机械加工)冷板以及圆管冷板。冷板内部流道可根据发热元件的功率采用不同方案,小功率元件冷板可直接采用 CNC流道、金属管嵌管等方案,大功率元件的冷板多采用铲齿工艺。当前,冷板产品的散热能力已能够全面覆盖主流芯片 TDP(Thermal DesignPower,热量设计功耗),并留有一定裕度。

冷板相变沸腾换热是热点技术方向。两相冷板技术通过冷板组件内的冷却液吸热发生相变,使绝大部分热量通过汽化潜热的方式被高效带走,因此散热能力更优。同时,冷却液在相变区域基本维持在饱和温度附近,显著减小了液体流动导致的纵向温度梯度,冷板与芯片传热接触面的温度分布更加均匀。两相冷板可通过优化内部流道结构或应用硅基材料、纳米复合材料等高导热系数材料,以强化内部相变换热过程。由于需要应对冷却液汽-液相态变化带来的压力剧烈波动、防止制冷剂蒸汽外溢,并尽可能减小局部阻力对系统整体压降的影响,两相冷板系统对冷板组件的承压能力、密封性以及流道结构的要求更高,系统的整体成本和工程控制难度也显著高于单相冷板。尽管如此,仍有企业看好两相冷板技术的未来发展前景,并积极开展相关技术研究储备。

2.冷却液

(1)领域全景

来源:中国信息通信研究院

图 6冷却液领域(2)发展态势

冷却液是核心热交换介质,按化合物类型可分为水基冷却液和非水基冷却液。水基冷却液可分为纯水和配方液,非水基冷却液可分为碳氢化合物、有机硅类化合物、碳氟化合物。冷板式液冷系统的冷却液在冷板流道中流动,不与主板和芯片等电子器件直接接触,在满足冷却性能的前提下,仅需考虑冷却液与循环管路、冷板之间的流动阻力、兼容性和长期可靠性,因此除两相冷板系统外,多采用水基冷却液,如纯水、乙二醇溶液、丙二醇溶液等。对于浸没式液冷系统,由于冷却液直接和电子器件接触,需保证冷却液在最不利工况下,仍然能够保持绝缘特性,故全部采用不含水的非水基冷却液。非水基冷却液包括油类物质(碳氢化合物、有机硅类化合物)和电子氟化液(碳氟化合物),其厂商主要包括 3M、美孚、中石油、壳牌、嘉实多、海斯福、巨化股份、浙江永和等。冷却液的选型需根据具体技术路线,综合评估其传热性能、环保性、材料兼容性、化学稳定性及成本等因素。当前,市场倾向选择单相冷板式液冷系统,水基冷却液凭借着良好的适配性以及更优的综合成本,已成为该技术路线的首要选择,占据着多数市场份额。

非水基冷却液不仅要求具备优秀的绝缘能力,同时还应满足严苛的性能及可靠性指标。在非水基冷却液的产品序列中,以全氟聚醚、全氟烯烃为代表的电子氟化液因其卓越的性能和广泛的适用性,持续受到业界的关注。电子氟化液的研发与生产难度较大,品质要求极为苛刻,需兼顾物理化学指标、环保指标、消防安全指标、健康安全指标、材料兼容性、电气特性等多个方面。国内市场中,前期电子氟化液市场长期由国外先进企业主导,产品价格较高,推高了浸没式液冷系统的使用成本。为打破这一市场格局,近年来国内众多氟化液厂商积极发力,通过加大研发投入、联合高校及科研院所、收购整合产能、构建全产业链能力等举措,已成功开发出多款性能优异的电子氟化液产品,部分指标逐步接近并达到国际先进水平,展现出国内企业在该领域快速追赶的势头。同时,在生态建设方面,开放数据中心委员会(ODCC)联合产业界持续深化研究,先后发布《浸没式冷却液可靠性规范》《碳氢化合物冷却液与服务器材料及健康环境兼容性研究》等多项重要成果,为冷却液产品的研发与应用提供了有力的技术支撑和标准化参考。展望未来,随着两相冷板、浸没式液冷等在技术研发与商业化进程中的持续突破,叠加标准体系的协同建设,国产电子氟化液产品体系有望加速完善,其市场应用空间也将得到进一步拓展。

3.快速接头

(1)领域全景

来源:中国信息通信研究院

图 7快速接头领域(2)发展态势

快速接头是液冷系统中的重要连接组件。快速接头主要用于机柜冷却液供回歧管与液冷服务器节点之间的连接与关断,通常由公头(插头)和母头(插座)组成,公母头在冷却液供回歧管和服务器上各有一个,互相配对使用。快速接头的设计强调可靠性、密封性、兼容性等能力,可根据插拔形式分为手插和盲插两种。手插快接头自带锁紧结构,运维人员无需借助其他工具仅通过手动推拉即可实现快速接头与其他连接器件的锁紧与断开,史陶比尔、中航光电、英维克、诺通、蓝科等国内外厂商均推出了基于 OCP标准的 UQD系列接头。盲插快接头则是通过设计浮动盲插结构实现公头母头的自动连接与断开,无需手动操作接头,因此在空间狭小的高密场景更具运维优势,其代表产品有史陶比尔 CGD系列、中航光电 TSF系列、华为的 CQDB系列等。以目前情况来看,手插快速接头因设计较为成熟、结构相对简单、采购与使用成本较低,仍是市场主流选择。然而,随着液冷智算中心对高密度部署与自动化运维要求的不断提升,盲插快速接头凭借其较高的空间利用率与较为便捷的运维操作,有望成为高密部署场景下的典型配置。

针对快速接头的标准化工作正持续推进。当前,业界针对快速接头产品的外观形态已基本达成共识,但在等效通径、插合长度、流通能力、轴向容差等方面仍存在较大的设计差异。接口规格和性能指标缺乏统一的技术规范约束,导致不同厂商间的产品无法实现解耦,对快速接头技术的持续创新与应用推广构成了潜在阻碍。中国信通院联合业界伙伴针对液冷快接头持续开展标准化研究工作,发布《不同品牌 UQD性能和可靠性互换性验证测试》《液冷盲插快接头发展研究报告》等多项研究成果,积极推进《冷板式液冷手插快接头测试方法》的编制工作,持续推动解耦交付模式的发展,旨在通过统一接头接口与技术标准,实现多厂商产品的互换适配,为行业构建有序的竞争环境、推动液冷技术的规模化应用奠定坚实基础。

4.冷量分配单元

(1)领域全景

来源:中国信息通信研究院

图 8冷量分配单元( CDU)领域

(2)发展态势

冷量分配单元( CoolingDistributionUnits,CDU)在液冷系统中

起到环路热交换以及冷却液流量分配两个关键作用。 CDU内部配置了用于一次侧环路(室外冷源侧)与二次侧环路(服务器节点侧)之间热交换的板式换热器,以及为二次侧环路提供动力的循环泵。同时,为保证系统安全平稳运行, CDU还配备了二次侧环路所需的调节、定压、补水、排气等装置。包括电动球阀、定压罐、补水箱 /袋、自动排气阀等,以及一次侧所需的温度、压力、流量、漏液的传感器以及相关的电气控制器件。 CDU根据布置方式不同,可分为分散部署的机架式 CDU和集中部署的柜式 CDU。按一次侧冷却方式不同,可分为风 —液式 CDU和液 —液式 CDU。目前,维谛技术、浪潮信息、英维克等厂商均推出了面向冷板式液冷系统、浸没式液冷系统、风冷改造等多个场景的 CDU产品。

厂商针对 CDU的升级主要围绕提升换热效率和防泄漏两方面展开。部分厂商从零部件入手,通过对管路材料与加工工艺进行改良,并对关键位置进行设计优化,实现了设备运行效率与换热效率的提升。例如,维谛技术在其冷板式液冷 CDU产品中引入全硬管连接技术,结合对板式换热器和水泵的设计优化,有效降低了系统流阻,提升了设备单位面宽的制冷能力。还有部分厂商从设备控制层面入手,基于温度、流量、压力等实时参数,并引入负荷预判策略,通过对水泵频率、阀门开度等进行预调节,实现冷却液流量的精准动态响应,提升 CDU在变负载工况下的调控能力。此外,针对系统漏液带来的安全性问题,浪潮信息等厂商提出了负压 CDU系统,该类系统利用真空泵对系统内部施加真空,并配合储液腔进行稳流,当系统出现泄漏,漏点会将空气吸入真空泵,通过气液分离器和消声器排出系统,即使与服务器的连接断开,也不会影响系统运行。从发展趋势来看, CDU产品的技术演进将更加注重系统级集成与精细化控制,包括进一步优化换热效率、实现更精准的流量调节,以及强化主动防漏能力,以满足液冷智算中心对能效、安全性和运维智能化要求。

5.一次侧系统

(1)领域全景

来源:中国信息通信研究院

图 9一次侧系统领域

(2)发展态势

智算中心的一次侧冷却系统负责承担一次侧环路中工质的冷却工作,系统包括室外冷源以及配套的水泵与管路。由于对芯片运行温度的设计考量不同,智算中心可分为一次侧 ≥35℃的高温水供水场景,以及一次侧 20~28℃的低温水供水场景。对于高温水供水场景,室外冷源多采用干冷器、闭式冷却塔以及开式冷却塔 +板换三种形式。其中,干冷器广泛应用在北方缺水寒冷地区,闭式冷却塔多用于湿热有水地区,冷却塔 +板换适用于有水地区且具有一定的成本优势。以上三种方式无机械补冷,冷源可通过风冷、喷淋的形式实现 100%自然冷却,因此具有极致节能的特点。对于一次侧低温供水场景,室外冷源多采用风冷冷水机组和闭式冷却塔 +机械补冷。其中,风冷冷水机组广泛应用在缺水寒冷地区,闭式冷却塔 +补冷系统多应用于高温高湿地区。由于一次侧需低温供水,此类场景下冷源需配置压缩机进行补冷,因此能耗相对偏高。目前,上述各类方案已在能效、稳定性与适应性之间实现了良好平衡,智算中心可根据供水温度需求及环境条件,灵活选择一次侧的冷源形式。

机械制冷方式持续升级以满足低温场景需求。低温供水场景要求采取一定的机械补冷措施以满足供水温度要求,但压缩机的存在势必将引起系统能耗的增加。为应对这一挑战,可通过采用磁悬浮变频水冷机组、氟泵空调等一系列低能耗制冷设备作为有效应对方案。磁悬浮变频水冷机组以磁悬浮压缩机为核心,利用磁铁特性实现压缩机的运动部件悬浮在磁衬上无摩擦的运动,减小了机械部件的摩擦损失,配合数字变频技术,提高了机组整体的制冷效率。氟泵空调则根据室外环境温度灵活切换压缩制冷和氟泵循环制冷两种模式,以达到降低运行能耗的目的。目前,上述技术已在行业内实现产品化并得到实际应用。对于自然冷却条件受限的地区,以及在芯片性能对低温环境依赖度较高的应用场景中,低能耗、高可靠性的机械制冷系统仍将持续发挥重要作用,并保有一定的市场需求。

6.冷却介质槽

(1)领域全景

来源:中国信息通信研究院

图 10冷却介质槽领域

(2)发展态势

冷却介质槽( Tank)是浸没式液冷系统的基础部件,其可靠性对系统运行至关重要。冷却介质槽是由槽钢拼焊组成外围框架,并在内部装配金属内胆而成的装配式结构。在系统运行时,冷却介质槽的内胆中会盛入大量冷却液介质,服务器等 IT设备以卧式形式放置在盛满冷却液介质的内胆中。介质槽外部通过管路与 CDU连接,由 CDU内部的循环泵驱动槽内冷却液循环流动,以达到 IT设备散热的目的。对于两相浸没式液冷系统,由于冷却液在介质槽内受热发生相变,冷却液蒸气体积膨胀,导致壳体内部压力过高,壳体膨胀变形,若此时壳体密封效果不佳,将会导致气态冷却液大量逸出,使冷却液发生明显损耗,并对运维人员健康产生影响。因此,两相浸没系统的冷却介质槽在设计时会重点考虑壳体材料、承压能力以及密封性能。相比之下,单相浸没系统由于冷却液始终以液相存在,系统内部压力波动较小,冷却液体不会发生明显溢出损耗,故冷却介质槽多以开放式结构为主。

多措并举以克服局部热点。浸没式液冷系统中,服务器节点普遍采用高密排布以充分发挥系统效能。然而,受温度梯度引起的冷却液密度差异以及管道入口局部流速过高等因素影响,介质槽内冷却液可能出现流动不均现象,导致部分服务器节点出现局部过热,进而影响 IT设备的稳定运行。为应对上述问题,业界已提出多种优化方案。一是在介质槽底部引入均流孔板结构,通过孔板对冷却液进行整流,有效改善流场分布,抑制回流与扰动,显著提升各服务器节点间的流量均匀性,降低同一水平截面内的冷却液温差。二是采用立式节点布局方案,使各浸没单元在结构上相对独立,在物理层面避免某一节点因产生热扰动而对邻近单元造成影响。此外,行业持续在高性能复合材料、一体化成型工艺等关键方向开展深入研究,以提升介质槽的结构强度、密封性能与制造效率。在应用需求持续推动下,冷却介质槽作为对外连接一次侧冷却系统、对内承接 IT设备换热的重要载体,其功能已不再局限于冷却液的承载容器,正逐步延伸成为集成强弱电连接、冷却工质管理、状态监控及运维辅助等多重功能的综合系统。

7.管路及阀门组件

(1)领域全景

来源:中国信息通信研究院图 11液冷管路及阀门组件领域

(2)发展态势

液冷管路与配套阀门协同作用,实现液冷系统各部件间的连接及冷却液的可控输送。液冷系统的连接管路按功能可分为 LCM(环路冷却液供回歧管)、 RCM(机柜冷却液供回歧管)以及配套软管。 LCM安装在机房地板底部或机柜顶部,负责将 CDU处的冷却液通过分支管路输送到 RCM或冷却介质槽处,其多采用环状管网布置方式,通过阀门开闭改变供液方向,以实现管路系统冗余。 RCM也称机柜冷却液供回歧管( Manifold),位于液冷机柜内部,用于连接服务器节点及 LCM。在 RCM上部或 LCM管路的端部位置,通常设置有排气阀,用于排出管路内部冷却液蒸汽以维持系统压力平衡。此外,管路系统还会集成电磁关断阀、电动调节阀及自动故障切换阀等组件,用于实现冷却液流量调控、异常工况下的快速隔离与系统冗余切换。从功能角度看,智算中心的液冷管路及阀门系统在加工工艺、材料选择等方面要求较为严苛,管路需考虑内壁粗糙度、承压能力、材质兼容性、材料疲劳寿命等因素。相应地,阀门组件须具备响应迅速、结构紧凑、密封可靠等特性。

标准化与智能化是液冷管路及阀门系统演进的核心方向。与快速接头类似,液冷管路系统的标准化设计对提升系统解耦能力及后期运维便利性至关重要。这要求产业链各方在洁净度等级、承压等级、疲劳寿命、管路公称直径与壁厚的执行标准等关键技术参数上达成统一规范。在此基础上,为满足液冷智算中心对智能化运维的更高要求,阀门作为系统流体调控的核心执行单元,应在持续优化材料与结构设计、保障复杂工况下长期稳定运行的同时,突破传统通断或比例调节功能局限,向集成传感、反馈与自适应控制能力的智能调控单元演进。通过与液冷智能控制系统深度融合,实现对流量、压力等关键参数的实时感知、精准调节与动态响应。标准化的管路系统与智能化阀门协同发展,将产生协同增效作用,在降低系统集成难度与运维成本的同时有效提升运行可靠性与能效水平。

(三)液冷 IT设备

液冷 IT设备是支撑液冷智算中心对外提供高效、可靠算力服务的关键基础,决定了液冷智算中心在算力、算效以及业务连续性等方面的综合能力表现。

1.冷板式液冷服务器

(1)领域全景

来源:中国信息通信研究院

图 12冷板式液冷服务器领域

(2)发展态势

冷板式液冷服务器市场占有率高。冷板式液冷服务器由冷板组件、主板、 CPU/GPU芯片、内存、硬盘、电源模块、风扇模块(可选)等部件组成,冷板组件覆盖在 GPU芯片等发热部件上,并通过内部管路与服务器机箱后端的快速接头公头相连,母头则经通过软管与机柜内部的冷却液供回歧管相连接,二者插接可实现管路连通,使冷板内部冷却液进行循环。作为智算中心冷板式液冷散热解决方案中的重要组成部分,近年来,冷板式液冷服务器得到了快速发展。从市场规模来看,据 IDC数据显示, 2024年中国液冷服务器市场规模达到 23.7亿美元,绝大部分服务器产品采用了冷板式液冷方案。相比其他类型的液冷技术,采用冷板式液冷技术对现有服务器结构改动较小,易于初期设计以及后期改造。此外,由于冷却液在服务器的冷板流道内部流动,不与发热芯片直接接触,因此冷板式液冷服务器受材料兼容性问题影响较小。目前,冷板式液冷服务器多采取冷板 +风扇组合的散热形式,通算服务器普遍支持 CPU液冷散热;智算服务器支持 CPU+GPU液冷散热,可选内存液冷散热。液冷板主要覆盖 CPU、 GPU等高功率电子元件,基本可满足主流服务器的散热需求。

芯片热设计功耗持续突破,催生冷板式液冷方案升级。在典型的冷板式液冷服务器散热系统配置中,液冷与风冷所承担的热负荷比例约为 6:4。但随着 AI服务器中高性能内存、网卡、硬盘等组件的持续迭代升级,其性能提升的同时发热量也显著增加,使风冷部分面临散热瓶颈。为此,业界提出全液冷冷板技术,即利用冷板全面替代散热风扇,以解决风冷散热效能不足的问题。除上述路径外,业界同时着手开展两相冷板技术的实践探索。该项技术依托冷却液相变实现高效换热,可应对 300W/cm2的热流密度挑战。目前,多家服务器厂商已完成对两相冷板技术的布局,随着成本控制与市场需求逐步趋于平衡,有望加速实现商业化落地。在行业多方力量的共同推动下,通过多元化技术路径的创新与实践,冷板式液冷服务器产品正加速走向成熟,其整体性能与能效水平得到了显著提升。

2.浸没式液冷服务器

(1)领域全景

来源:中国信息通信研究院

图 13浸没式液冷服务器领域

(2)发展态势

浸没式液冷服务器总体可靠。浸没式液冷服务器在组件构成上与传统服务器相似,主要区别在于取消了散热风扇设计。其核心特点是将整个机箱及其内部组件完全浸没于冷却液中,使发热器件与冷却液直接接触,通过冷却液的流动循环带走设备热量。由于运行环境发生显著变化,服务器厂商在产品设计初期即会对设备壳体、印刷电路板、高速信号过孔、连接器及线缆等关键部件实施针对性优化,确保设备在冷却液中长期浸泡时具备良好的材料兼容性与信号传输稳定性。同时,通过配置专用电源,以满足设备高密度部署的供电需求。目前,新华三、浪潮信息、宁畅、华鲲振宇等国内服务器厂商均已推出多个系列的浸没式液冷服务器产品,广泛应用于智能计算、高性能计算等场景,有较为丰富的市场实践。在电源配套方面,欧陆通等专业电源厂商也开发出了多种适配不同规格需求的电源解决方案,覆盖浸没式液冷环境下的集中式与分布式供电方案,为浸没式液冷系统的供电提供了多样化产品支撑。

强化换热能力成为业界共识。单相浸没式液冷服务器依托冷却液与芯片间的无相变热传导实现散热,提升换热面积、优化流场分布是实现高效热量转移的两个关键途径。新华三集团联合 Intel、埃克森美孚及绿色云图共同研发推出 "G-Flow"浸没式液冷服务器,该方案采用埃克森美孚高性能合成油作为冷却介质,通过在芯片表面安装特制 "漏斗型 "散热器,配备密集散热鳍片,并在散热器底部配置定向导流管,使冷却液依靠重力作用经导流管全部流经散热器,显著提升了整体换热效率。此外,有部分厂商通过引入外部驱动部件,如封闭风机、微泵等,利用强制对流的方式,加大服务器内芯片局部区域的冷却液流速,强化区域内的湍流程度,以实现更优的换热效果。对于两相浸没式液冷服务器而言,相变传热是其主要散热手段。系统在运行过程中会经历自然对流传热与核态沸腾两个阶段,当服务器芯片表面温度达到阈值,而冷却液未能及时发生沸腾,将导致热量积聚并引发芯片过热。为此,业界在采用沸点适中、特性稳定的冷却液的基础上,同样关注芯片表面强化技术的应用。例如在芯片表面设置不同类型的翅片,胶合粗糙表面材料,引入多孔介质或涂覆微孔涂层等。可以预见的是,随着材料学、流体力学与芯片封装技术的协同创新,两相浸没式液冷服务器换热能力有望实现更高突破。

3.液冷交换机

(1)领域全景

来源:中国信息通信研究院

图 14液冷交换机领域

(2)发展态势

液冷交换机是面向智算场景的核心网络设备。 AI大模型分布式训练需求持续旺盛,为满足大规模 GPU集群组网需求,交换机对交换容量、端口速率、缓存等关键性能指标的要求日益严苛,交换机内部的交换芯片、 SerDes(串行器 /解串器)等核心组件功耗急剧上升,主流 51.2Tbps交换芯片的功耗普遍介于 500W~900W。受交换机设备空间尺寸的严格限制,散热鳍、热管、 3DVC等风冷增强技术已步入瓶颈。为确保交换机核心组件工作在安全温度区间,避免因过热引发设备宕机,造成网络大面积瘫痪,业界加速推进液冷交换机研发进程。目前,市场上的液冷交换机产品已涵盖冷板式与浸没式两类液冷方案,可支持主流的高密度 100GE/25GE端口,部分高端型号已具备对 800GE/400GE端口的支持能力。

800G液冷交换机有望在未来几年实现规模化应用。近年来随着智算中心集群规模的持续扩展以及智算业务形态的不断演进,智算中心网络在流量、带宽、时延等方面呈现出多样化特征,对网络带宽、数据传输速率等指标提出了更高要求,进而推动了 800G/1.6T以太网的持续突破。自 2018年起,全球主流交换机厂商陆续推出 400G交换机产品。短期来看,液冷交换机市场整体呈现平稳发展趋势,市场仍以 100G/400G产品为主,中长期来看,随着各通信厂商正积极向 800G以太网过渡, 800G液冷交换机产品也正逐步进入落地阶段,未来将有望快速发展。此外,在交换机热点技术方向,如共封装光学(CPO, Co-Packaged Optics)和邻近封装光学( NPO, Near-Packaged Optics),正逐步与液冷技术深度融合。通过采用一体化冷板设计,对交换芯片及光引擎进行集成式覆盖冷却,可有效应对 CPO/NPO架构下的集中热源散热挑战。液冷技术的成功应用不仅缓解了传统风冷大容量交换机的散热瓶颈,也为智算中心实现高效组网并充分发挥计算节点性能提供了有力支撑。

4.液冷光模块

(1)领域全景

来源:中国信息通信研究院

图 15液冷光模块领域

(2)发展态势

光模块是光纤通信系统中的核心器件。光模块主要由光发射组件、光接收组件、驱动电路和光电接口等组成,负责在光通信链路中实现电信号与光信号的相互转换。当前,智算中心大规模数据传输需求推动交换机朝着高密度端口、大网络带宽方向发展,算力中心互连技术正经历从传统铜缆到光互连的剧烈变革,进而推动光学互联技术持续迭代升级。光模块作为光信号收发的重要组件,其性能与寿命高度依赖适宜的工作温度。为确保数据可靠传输,包括可插拔光学元件在内的大多数光学组件通常需保持在 70℃以下。随着数据吞吐量的不断增长,光模块设备的散热问题变得日益突出,促进了液冷技术在光模块产品上的创新应用。

光模块厂商寻求创新突破,形成冷板式和浸没式两类技术产品。在冷板式液冷技术方向上,厂商通过将光模块原有集成散热器替换为配备快速接头的集成冷板,配合防漏液盲插连接设计,使光模块在插入后自动连接到冷却液管路,利用冷板实现了对光模块的高效散热。在浸没式液冷技术方向上,厂商更关注产品的防渗入能力,通过对 PCBA进行整体封胶,并优化光口密封设计,以防止冷却液进入光路。未来,随着智算中心数据吞吐量的不断增长,其热管理需求将持续推动液冷光模块产品创新发展。

(四)液冷系统技术服务

液冷技术服务可划分为机柜级解决方案、机房级解决方案以及液冷智能控制系统三方面内容。通过从局部到整体的分层设计与协同管理,可有效满足各类部署场景对灵活性、可扩展性及运行效率的综合需求。具体来说,全栈解决方案可有效降低液冷系统的整合与适配难度,加快部署速度,并降低应用门槛。先进的智能控制系统通过实时监测与精准调控,确保系统可以有效应对负载波动,始终处于最佳效能状态。

1.液冷机柜系统解决方案

(1)领域全景

来源:中国信息通信研究院图 16液冷机柜系统解决方案领域

(2)发展态势

整机柜交付模式可有效降低液冷系统部署难度。对于设备规模有限且缺乏运营经验的潜在用户而言,其资金投入与技术能力难以满足液冷系统在建设、运维等方面的综合门槛,制约了液冷技术的普及应用。业界厂商精准把握用户需求,通过集成计算节点、液冷机柜及配套管路、阀件等组件,并依据负载配置冷却分配单元,形成了一套完整的液冷整机柜解决方案。例如,超聚变面向智算中心典型应用场景推出 FusionPoDforAI液冷整机柜解决方案,机柜采用电、网、液三总线盲插设计,并配有单柜智能管理系统,实现了整机柜的快速交付与便捷运维。百度联合英特尔面向浸没式液冷场景推出天蝎 5.0浸没式液冷机柜,集成了冷却介质槽、浸没式服务器节点、供电系统、冷

却液以及连接管路等,降低了浸没式液冷系统的适配成本。从目前市场情况来看,整机柜交付模式正逐渐成为主流。

解耦交付模式更利于产业良性发展。伴随业务的调整,智算中心用户普遍面临算力扩展、设备更新等需求,这便要求液冷机柜在设计之初需要具备灵活扩展能力,以适应不同配置的服务器的部署需要。目前液冷整机柜多采用一体化交付模式,机柜、服务器、零部件均由交付厂商按自有标准进行集成和开发,此举虽然降低了用户适配难度,但也导致用户与厂商深度绑定,为服务器分批上架部署及后期更新替代造成阻碍。解耦交付模式以服务器为边界,建设方负责液冷机柜及相关配套的部署,并预留 Manifold接口,企业则可根据业务需求自主定制服务器。该模式显著提升了设备部署的灵活性,更利于市场的良性竞争。目前,中国信通院已联合业界厂商持续推进液冷设备解耦相关标准研究与测试工作,中国移动、中国电信、中国联通三大电信运营商也针对机柜服务器解耦稳步开展测试验证。

2.液冷机房级解决方案

(1)领域全景

来源:中国信息通信研究院图 17液冷机房级解决方案领域

(2)发展态势

液冷机房级解决方案是集基础设施、服务与软件于一体的综合方案。伴随液冷产业链的不断延伸,上游厂商依靠研发积累与实践经验,持续拓展产品矩阵,在整机柜交付方案基础上,通过整合智控系统、配电系统及室外冷却塔等,具备了从一次侧冷源到二次侧计算节点的端到端液冷解决方案的能力。例如,维谛技术面向智算场景推出 Vertiv.AIGC全栈液冷解决方案,方案涵盖了浸没式液冷和冷板式液冷两种主流技术路径,集成了包括室外冷源、 Tank/冷板液冷机柜、 CDU、供配电及环控等在内的多个关键子系统,可应对高密部署挑战。兰洋科技推出浸没式液冷高密度算力节点,利用全浸没式液冷集装箱户外部署,构建了集土建地基、服务器运行环境、供配电及 UPS系统、网络系统、散热系统、动环监控系统监测、消防系统及智能运维系统于一体的综合性产品解决方案,以满足多场景快速部署需求。

液冷智算中心的建设热潮正推动建设模式的持续革新,预制模块化技术助力液冷系统快速部署。业务快速上线的需求显著压缩了液冷智算中心的建设周期,为工程实施带来了极大挑战。液冷系统预制模块化技术通过解耦液冷系统功能,将系统划分为冷源模块、控制模块、水力模块等独立单元,设备运抵现场后仅需完成电缆与管路连接即可投入运行,具备高度集成化与快速部署的优势。液冷系统包含大量管路与阀门组件,采用预制化模式可将主要部件的生产与组装转移至受控的工厂环境,有效规避现场焊接安装可能引发的施工缺陷与人为失误。同时,模块化设计支持从生产到运维的全生命周期追溯,便于故障模块的快速更换,显著降低了后期运维难度与维修停机时间。鉴于液冷系统预制模块化技术涉及制冷、 IT设施、自动控制、电气等多专业的深度协同。因此,仅有少数具备综合技术实力的厂商在积极布局相关产品,该技术的全面推广尚需时日。

3.液冷智控系统

(1)领域全景

来源:中国信息通信研究院

图 18液冷智控系统领域

(2)发展态势

液冷智控系统具备基础监控、设备管理与系统调优功能。液冷监测与控制系统作为智算中心环境配套基础设施的核心辅助生产系统,具有完善的风险监控与故障报警能力,可实现与其他监控管理系统数据的通信和集成,是数据中心基础设施管理系统( DCIM)在制冷系统层面的重要依托。通过分布在系统不同点位的各类智能传感器,液冷智控系统可实现对机房环境温度、 CDU负载、液体渗漏、管路流量与压力、电动阀开度、液质等一系列运行数据的实时监控和记录。基于对运行数据的持续采集与深度分析,并依托智能化运维平台,系统能够识别潜在运行风险与优化空间,并据此生成涵盖配置调整及维护策略等方面的精准运维建议,从而有效提升液冷系统的运行可靠性与整体稳定性。

精准化与智能化成为液冷智控系统发展的核心方向。近年来,智算中心逐渐呈现大型化和集约化发展趋势,其业务负载也呈现出高增幅、高并发的特点。液冷智能控制系统作为保障智算中心平稳运行的关键一环,提升全面感知与调控能力尤为重要。为此,可通过融合高精度传感器硬件与先进的数据采集处理系统,实现对温度、流量、压力等关键参数的实时、精准监测。基于采集数据,结合人工智能算法进行分析与预测,动态优化调控策略,实现对冷却设备的精准控制。普洛斯提出了一套基于大型冷板式液冷算力中心的群控方案,通过群控主机协调多个冷板和 CDU的运行,实现了冷板负载的动态调节。润泽科技自主研发的 “智能低碳全域制冷系统 ”通过结合冷板式液冷及近端风墙散热技术,并融入 AI智能运维系统,实现了服务器全域制冷并提高了智算中心的整体节能效率。液冷智算中心的革新奠定了 AI发展基础, AI技术的持续迭代也为底层基础设施智能化升级提供了技术牵引。未来,构建基于 AI预测的主动式液冷控制体系,将成为实现液冷智控系统更加精准、高效与智能化的重要路径。

(五)液冷技术应用赋能

随着我国数字化转型的持续深入,液冷智算中心在支撑千行百业高质量发展中的作用日益显著,其综合赋能价值得到进一步释放。

1.液冷智算中心建设领域

(1)领域全景

来源:中国信息通信研究院

图 19液冷智算中心建设领域

(2)发展态势三大运营商稳步推进液冷智算中心建设。为应对 AI时代的多样性算力需求,并满足日益趋严的 PUE指标监管,中国移动、中国联通、中国电信三大运营商积极谋划液冷智算中心布局,稳步推动液冷技术在智算中心中的实践应用。 2024年,三大运营商均有液冷万卡算力集群投入运营。中国移动在内蒙古投产使用中国移动智算中心(呼和浩特)项目,项目采用冷板式液冷技术,用于支撑大模型训练等高算力需求场景。中国电信正式启用天翼云上海临港国产万卡算力池,项目采用智算液冷 DC舱,充分满足了多场景科研创新和产业算力需求。中国联通上海临港智算中心正式交付,是中国联通首个全液冷国产超万卡智算集群。此外,三大运营商联合发布的《电信运营商液冷技术白皮书》在针对液冷技术的规模推广中提到, “经测试验证, 2025年及以后在电信行业规模应用 ”,彰显了其全面推广液冷技术的战略决心。

IDC运营商积极部署液冷算力中心。智算需求的爆发切实影响着第三方服务商的业务布局,部分企业抢先谋划建设液冷智算中心,加速推进液冷技术研发与应用。秦淮数据持续推动 “玄冰 ”冷却架构迭代升级,通过整合风冷、液冷及风液兼容等模块,全面满足 8kW~150kW功率密度机柜的冷却需求。世纪互联华北云计算中心基地项目因地制宜采用 “风-液 ”混合架构,系统可依据负载平滑调节风、液比例,实现设备按需冷却。此外,润泽科技、万国数据、普洛斯、有孚等企业也正加紧相关布局,持续推动液冷智算项目落地。中国信通院曾就液冷智算中心的未来部署规划,对主流第三方算力中心服务商进行了调研。调研结果显示,多数企业在新建智算中心项目中倾向于采用冷板式液冷系统,因其具备较高的散热效率,且相关技术已趋于成熟与可靠,能够满足中短期业务发展需求。同时,也有部分企业表示,将根据未来发展态势及企业发展战略灵活调整方案的选择,不排除选择浸没式液冷系统的可能性。

2.液冷智算中心服务领域

(1)领域全景

来源:中国信息通信研究院

图 20液冷智算中心服务

(2)发展态势

互联网持续释放发展活力,对智算中心液冷技术的规模化应用起到催化作用。一方面,互联网行业作为人工智能等前沿数字技术的重要应用平台和发展载体,其庞大的用户群体和丰富的应用场景催生出了远超过其他领域的智算需求,进而从需求端拉动高功率服务器散热技术的革新。另一方面,在国家 “双碳 ”目标以及各类能耗政策的牵引下,迫切需要通过设施层面的迭代升级以满足趋严的能耗监管要求。目前,高效节能的液冷技术已得到了互联网厂商的充分认可,服务于互联网领域的液冷设备规模占到了市场总体规模的一半以上。腾讯、百度、字节、阿里巴巴等互联网企业围绕液冷技术持续开展创新实践,采用自建或与第三方算力中心服务商合作的方式加速液冷算力中心的布局,通过算力、算效的双重提升保证自身业务平稳扩张。

智算中心下游用户日益多样化,带动液冷产业规模进一步扩大。智能算力的应用正加速从互联网领域向金融、制造、交通、医疗等全行业渗透,成为传统产业数字化、智能化转型的重要支点。随着社会数字化进程不断加快,应用需求的激增将对现有智算资源造成较大考验。未来,各行业在智算基础设施方面的布局将会保持加速状态,投入也将持续创出新高,液冷智算中心将在多个领域实现更为广泛的覆盖和更深层次的应用。

四、智算中心液冷产业发展建议

本报告从全景视角出发,梳理并绘制了智算中心液冷产业的全景态势,旨在充分把握其发展脉络,识别关键问题和瓶颈并加以分析,以期促进液冷产业的蓬勃发展。通过梳理我们发现,当前我国智算中心液冷产业发展面临创新不足、标准体系缺失、责任界面模糊、产业链协同不足等问题。对此,报告给出以下四点发展策略建议,供业界参考:

(一)加速技术研发迭代,探索多领域应用场景

加强液冷前沿技术研究。液冷系统作为传统风冷散热系统的高效替代方案,需要持续的技术创新来激发商业化应用活力。针对市场占有率较高、技术相对成熟的冷板式液冷系统,厂商应持续锻造优势,重点加强冷板换热结构的优化设计及新型导热材料的研发,加大对系统余热回收、智能运维等关键环节的技术投入,推动冷板式液冷技术向精细化、智能化方向不断演进。同时,也应准确把握业界对极致散热的需求,针对浸没式液冷系统开展包括但不限于冷却液的国产替代、材料兼容性、信号完整性等方面的研究工作。

拓展应用场景。旺盛的市场需求是推动液冷技术进步的一项关键因素,智能算力的发展使得智算中心对液冷技术的依赖持续增强,液冷已成为支撑高密度算力部署的核心解决方案。与此同时,随着生物医药、工业仿真等领域对高性能计算需求的不断攀升,以及云边端协同场景的持续落地,超算中心与边缘计算节点对高效散热的需求日益凸显,进一步拓宽了液冷技术的应用边界。鉴于此,产业界在深耕智算中心液冷领域的同时,需要同步探索面向超算、边缘计算等新型应用场景的技术研发和系统适配工作,进一步推动液冷在更广泛领域的普及和应用。

(二)加强标准规范制定,引导产业全链条有序发展

建立健全完善标准体系。标准化建设是推动液冷产业平稳发展和持续创新的核心要素。现阶段,围绕智算中心液冷技术的国家标准、行业标准及团体标准尚不完备,缺乏系统性的规范框架,导致产业界各方面临设计无据可依、集成适配困难、责任边界模糊等挑战。产业界应加速推进相关标准的制定工作,形成完善立体的液冷技术标准体系。针对应用比例较高的冷板式液冷技术,应积极出台涵盖后期改造、运维管理、安全评估等系列标准。针对发展势头良好的浸没式液冷技术,应积极围绕信号完整性、材料兼容性等关键性问题开展标准制定工作。同时,应鼓励产业链上下游各主体积极参与标准制定,结合自身实践经验和技术创新成果,提出具有针对性和实用性的建议,以确保标准更加贴合实际需求。

加强产品测试认证。液冷对算力领域而言仍属于新兴技术范畴,由于缺乏长周期、规模化部署验证,部分用户对于液冷产品的可靠性、安全性、有效性等仍存在疑虑。产业界应加速开展面向智算中心液冷系统相关的产品与解决方案的测试认证工作,通过引入客观公正的测试认证帮助市场建立信心,并通过有效评估帮助厂商了解和提升产品性能。可重点依托中国信通院 “液界先锋 ”测试体系,持续开展液冷服务器、快速接头、冷却液等关键技术要素的评估与测试工作。同时,对筛选出性能突出、运行稳定可靠的产品或解决方案进行宣传推广,树立可推广、可复制、高价值的标杆产品应用,促进技术迭代以及行业规范化发展。

(三)推动分类分级与权责划分,健全液冷产品质量控制体系

推动液冷产品分类分级。当前液冷产品种类繁多,技术指标与性能参数缺乏统一基准,导致产品间横向对比困难,用户方选型多依靠厂商自身宣传及市场口碑,增加了用户方的决策难度,也不利于技术先进但品牌影响力较弱的企业充分拓展市场空间。通过建立明确的分类分级标准,用户方可基于确定的参数指标,对不同品牌的液冷产品进行横向对比,快速识别符合自身需求的产品等级。同时,分类分级测试通过将产品性能量化,可明确不同等级产品的质量下限,并形成有效的市场筛选机制,加速行业由价格竞争转向技术竞争,进而推动液冷产品向高性能、高可靠、高兼容方向持续迭代。

明确界面责任划分。液冷智算中心涉及基础设施层、 IT设备层、应用服务层等多个物理层级。各层级之间紧密结合、相互依托,共同保障算力服务平稳运转。明确界定各环节责任,本质是通过规则前置化和权责透明化,将智算中心复杂系统的管理从 “应急处置 ”转向 “主动防控 ”。例如,当系统出现故障,明确的责任归属一方面可快速锁定责任主体,缩短故障排除与修复时间。同时,也从源头倒逼设备供应商主动履行技术标准,保障硬件产品质量。明确界面责任划分不仅解决了 “谁来负责 ”的问题,更通过机制设计驱动各方提升专业性和责任感,最终实现液冷智算中心安全、高效运行。

(四)强化产业链协作,构建良好的液冷产业链生态循环

推动硬件设备实现解耦。现阶段液冷产业链众厂商技术路径多样,产品规格迥然相异,各类产品的标准化程度不高,兼容性不足,影响了液冷系统规模化部署与后期设备升级。液冷产业链各主体应加强在产品设计、生产、制造环节的标准化协作,鼓励专利开放共享。针对液冷系统关键位置部件,推动结构、尺寸等方面的规范化设计。以解耦为核心抓手,逐步构建开放、兼容、可扩展的液冷生态系统,为行业规模化、可持续发展奠定坚实基础。

加强产业链整体协同实现降本增效。液冷智算中心在全链条成本优化与效率提升方面仍存在提升空间,产业各方应围绕原材料供应、设计制造、系统集成及运维等环节加强协同,进一步形成合力。在原材料端,应加快冷却液等关键材料的本地化研发与生产,构建多元、弹性的供应体系,保障材料的稳定供给和成本可控。在设计制造端,应积极建立协同研发机制,鼓励服务器厂商、芯片厂商、冷却液厂商多方深度参与,统筹考虑工艺、性能、成本因素,实现最优匹配。在系统集成端,应充分聚焦标准化、模块化产品开发,推广 “即插即用 ”的一站式解决方案,提升部署效率、降低适配成本。在运维端,应积极引入全生命周期管理系统,并联合设备厂商制定预防性维护策略,通过科学管理和技术手段保障算力业务的平稳运行。

中国信息通信研究院云计算与大数据研究所

地址:北京市海淀区花园北路 52号 邮编: 100191

电话: 010-62302074

传真: 010-62302074

网址: www.caict.ac.cn

关于我们

北京汉深流体技术有限公司在此次年会上再获殊荣 —— 成功蝉联丹佛斯动力系统 2025 财年 “卓越成长 业绩突破奖(Performance Outstanding Award)”。这是汉深流体继 2024 财年后再度斩获该奖项,既是丹佛斯对其业绩高速增长、市场拓展能力的高度认可,更彰显了汉深流体在数据中心液冷连接领域的专业积淀与行业标杆地位。汉深产品包括FD83全流量双联锁液冷快换接头(互锁球阀);液冷通用快速接头UQD & UQDB;OCP ORV3盲插快换接头BMQC;EHW194 EPDM液冷软管、电磁阀、压力和温度传感器。在人工智能AI、国家数字经济、东数西算、双碳、新基建战略的交汇点,公司聚焦组建高素质、经验丰富的液冷工程师团队,为客户提供卓越的工程设计和强大的客户服务,支持全球范围内的大批量交付。

公司产品涵盖:丹佛斯液冷通用零泄漏快换接头、EPDM软管、电磁阀、压力和温度传感器及Manifold。

未来公司发展规划:数据中心液冷基础设施解决方案厂家,具备冷量分配单元(CDU)、二次侧管路(SFN)和Manifold的专业研发设计制造能力。

数据中心液冷解决方案 ~ 满足您各种需求的一站式解决方案:

- 主线解决方案:Danfoss Hansen FD83 系列全流量双互锁接头

- 机架内部解决方案:基于OCP标准全新打造的液冷通用快速接头UQD & UQDB ;OCP ORV3盲插快换接头BMQC , 支持全球范围内的大批量交付。

- Danfoss Hansen MQD and MQDB 液冷快换接头: MQD02 (H20); MQD03 (Blackwell B300 GB300); MQD04;MQDB03 and MQDB04。

- 针对机架式服务器中Manifold/节点、CDU/主回路等应用场景,提供不同口径及锁紧方式的手动和全自动快速连接器。

- 针对高可用和高密度要求的刀片式机架,可提供带浮动、自动校正不对中误差的盲插连接器。以实现狭小空间的精准对接。

- 液冷软管:EHW194 EPDM(三元乙丙橡胶)软管,最高防火等级(UL94 V0) 的软管

- 制冷剂解决方案: 5400系列制冷剂接头和GH001和EZ卡扣式配件。

- 液冷服务器、液冷板、CDU、液冷接头、管路、Manifold、液冷泵\阀门、换热器、冷却塔、漏液检测、液冷模块、过滤器、激光焊接、清洁度检测等。

About Us

Beijing Hansen Fluid Technology Co., Ltd. is an authorized distributor of Danfoss China, specializing in the data center industry. Our product portfolio includes Danfoss FD83 full-flow double-interlock liquid cooling quick-disconnect couplings (equipped with interlocking ball valves); universal liquid cooling quick-disconnect couplings UQD & UQDB; OCP ORV3 blind-mate quick-disconnect couplings BMQC; EHW194 EPDM liquid cooling hoses; solenoid valves; and pressure/temperature sensors. Amid the convergence of strategic trends such as artificial intelligence (AI), China’s national digital economy, the “Eastern Data and Western Computing” initiative, the “dual carbon” goals, and new infrastructure development, we are committed to building a high-caliber, experienced team of liquid cooling engineers. We deliver exceptional engineering design, robust customer service, and support global large-scale deployment.

Products: Danfoss liquid cooling fluid connectors, EPDM hoses, solenoid valves, pressure/temperature sensors, and manifolds.

Development Plan:Our goal is to become a leading provider of liquid cooling infrastructure solutions for data centers, with professional R&D, design, and manufacturing capabilities for cooling distribution units (CDUs), secondary fluid networks (SFNs), and manifolds.

Data center liquid cooling Solutions ~ One partner, every solution :

- Source line solutions: Danfoss Hansen FD83 Series Full-fow dual-interlock coupling

- Inner rack solutions: Newly engineered universal liquid cooling quick connectors UQD & UQDB compliant with OCP standards; OCP ORV3 blind-mate quick-disconnect connectors BMQC, supporting mass delivery on a global scale.

- Inner rack solutions: Danfoss Hansen MQD and MQDB Liquid Cooling Quick-Disconnect Connectors: MQD02 (H20); MQD03 (Blackwell B300 GB300); MQD04; MQDB03 and MQDB04.

- For application scenarios including Manifold/node, CDU/main loop in rack-mounted servers, manual and fully automatic quick connectors with different calibers and locking mechanisms are available.

- For blade racks requiring high availability and high density, blind-mate connectors with floating function and automatic misalignment correction are offered to enable precise docking in confined spaces.

- Liquid Cooling Hoses: EHW194 EPDM (Ethylene Propylene Diene Monomer) hoses, featuring the highest fire rating (UL94 V0). Hoses with UL94 V0 rating — leads the industry

- Refrigerant solutions: 5400 Series Refrigerant Connectors, along with GH001 and EZ Snap-Fit Fittings.

- Liquid cooling servers, liquid cooling plates, CDUs, liquid cooling connectors, pipelines, Manifolds, liquid cooling pumps/valves, heat exchangers, cooling towers, leak detection systems, liquid cooling modules, filters, laser welding, cleanliness testing, etc.

|